GPU推理期间闭幕?宇宙最大芯片加合手推理狂飙20倍

LLM若想高速推理,现如今,连GPU都无法知足了?

曾造出宇宙最大芯片公司Cerebras,刚刚发布了寰球最快的AI推理架构——Cerebras Inference。

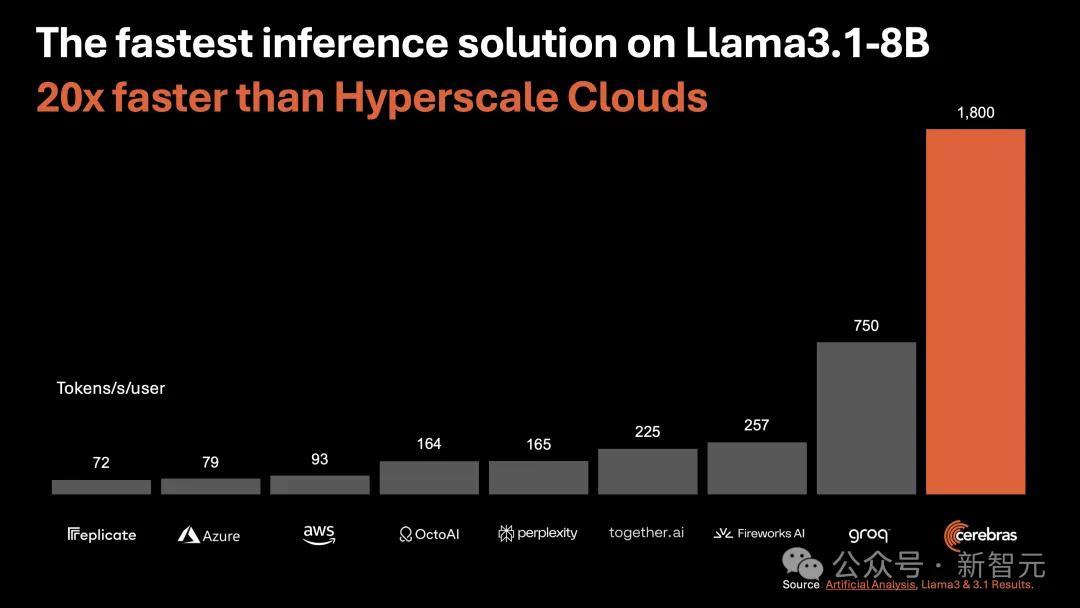

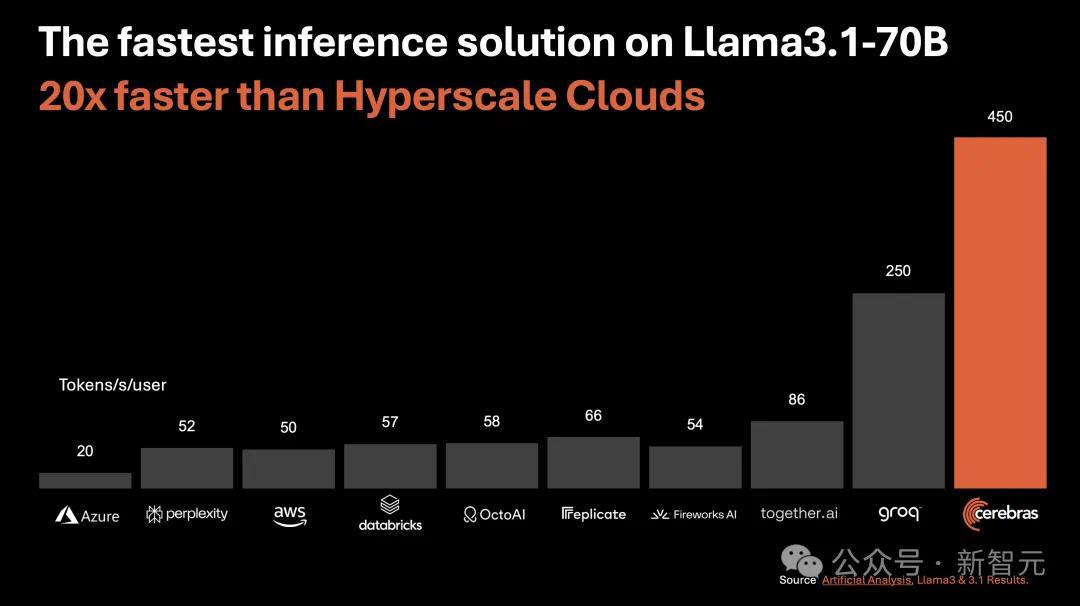

来源Llama3.1 8B时,它能以1800 token/s的速率吐出笔墨。

岂论是转头文档,一经代码生成等任务,反应险些一闪而过,快到让你不敢敬佩我方的眼睛。

如下图右所示,以往,微调版Llama3.1 8B推理速率为90 token/s,明晰可见每行笔墨。

而目下,径直从90 token/s跃升到1800 token/s,相配于从拨号上网迈入了带宽期间。

左边Cerebras Inference下模子的推理速率,只可用「眨眼间」、「荒诞」两字形容。

掀开新闻客户端 擢升3倍流通度这是什么见识?

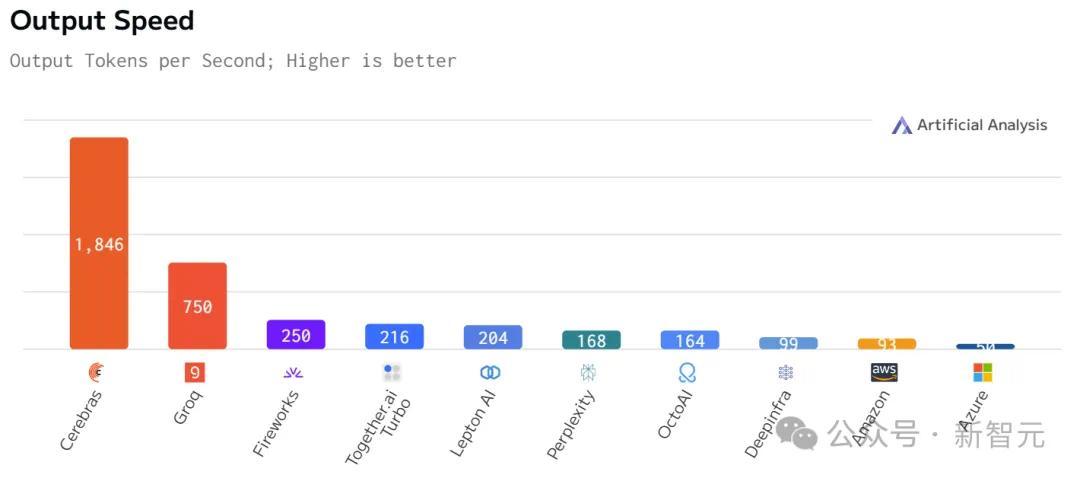

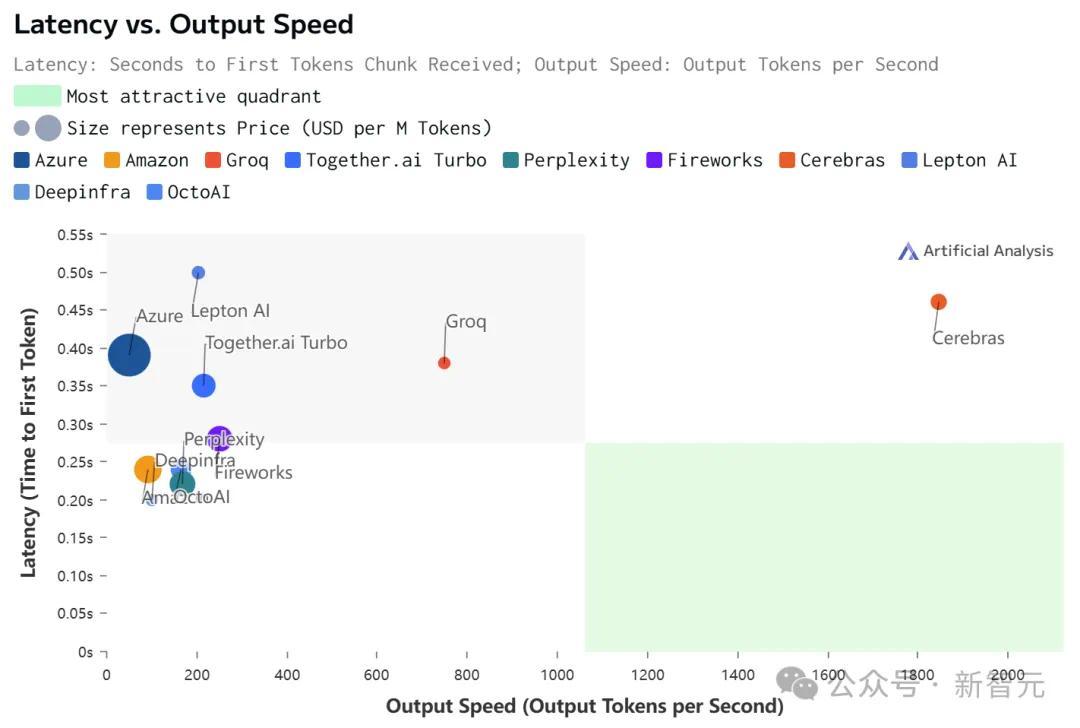

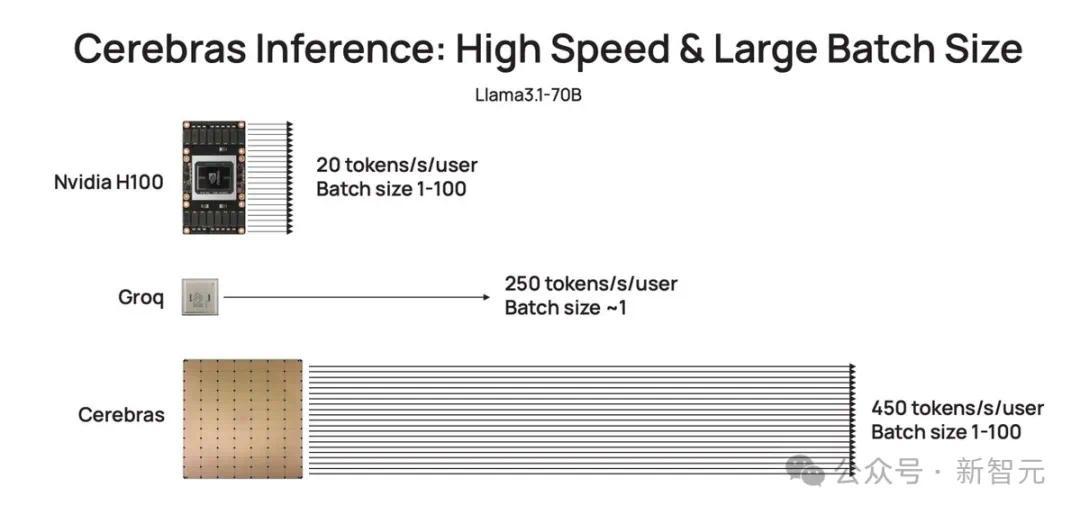

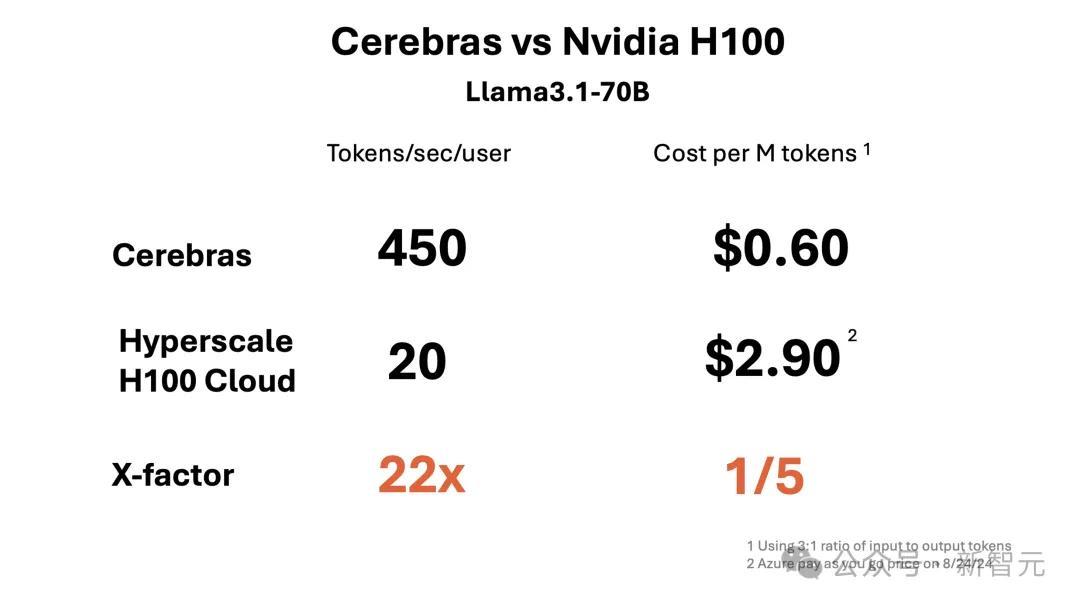

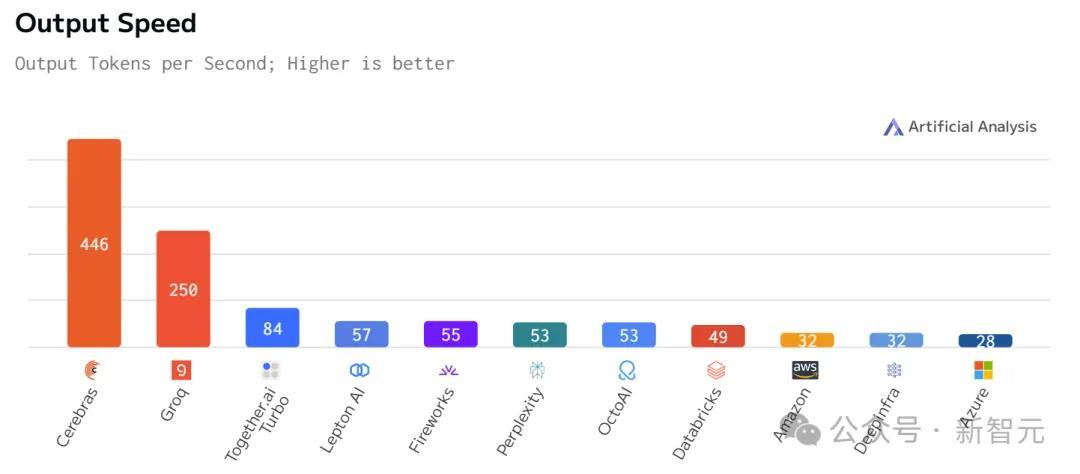

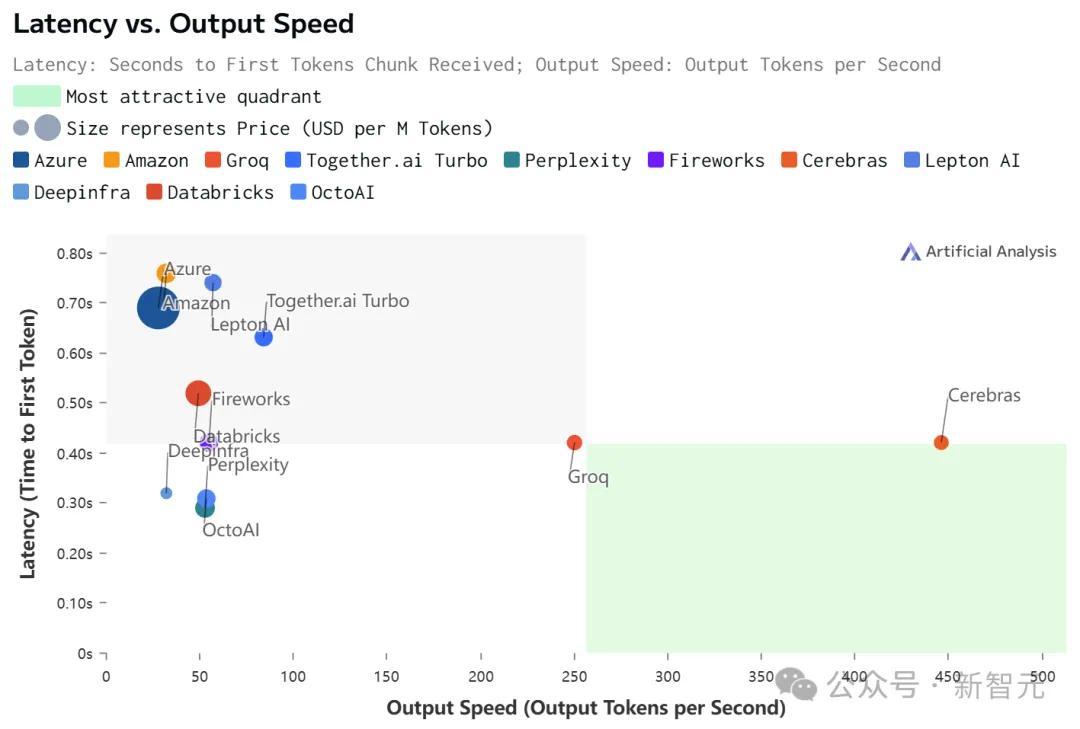

比起英伟达GPU,Cerebras Inference的推理速率快20倍,还要比专用Groq芯片还要快2.4倍。

另外,关于70B参数的Llama3.1,可达到450 token/s实时反应。

值得一提的是,Cerebras并莫得因为提高LLM的速率,而赔本其精度。

测试中,使用的Llama3.1模子皆是接收了Meta原始16位权重,以便确保反应高精度。

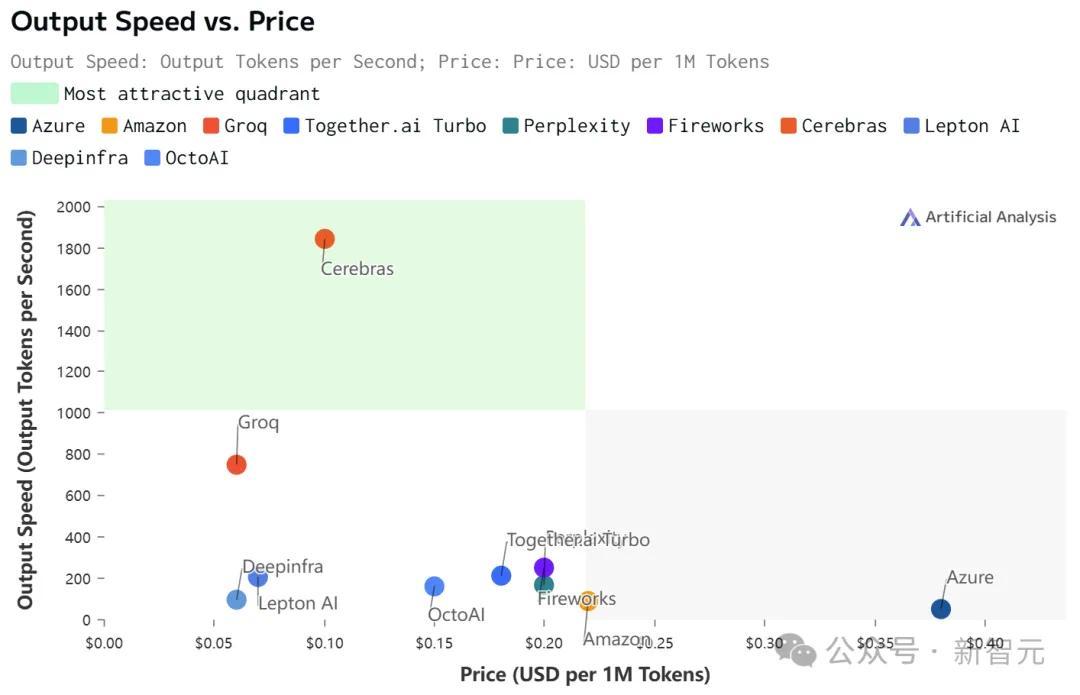

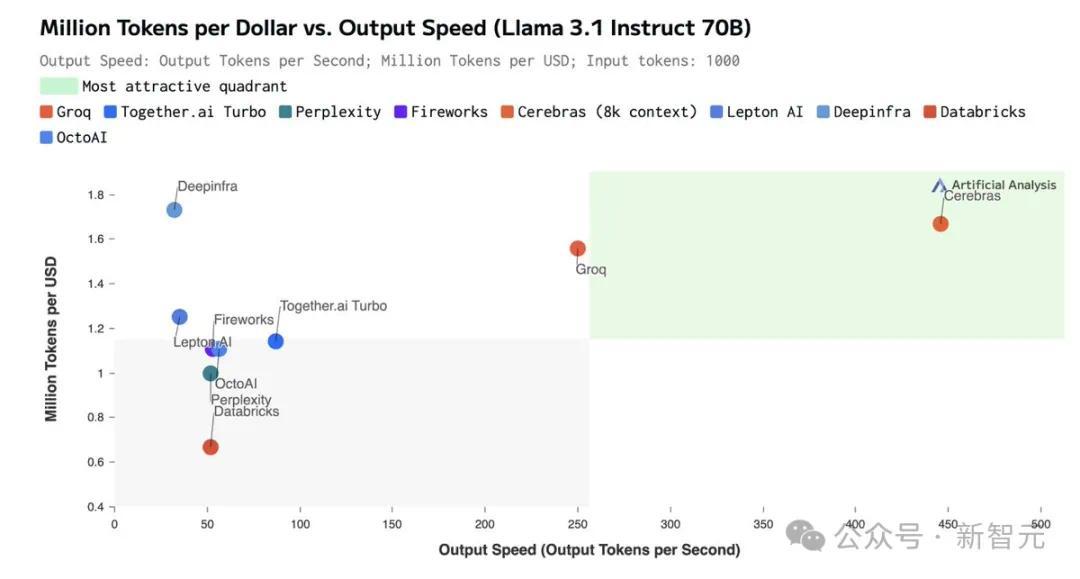

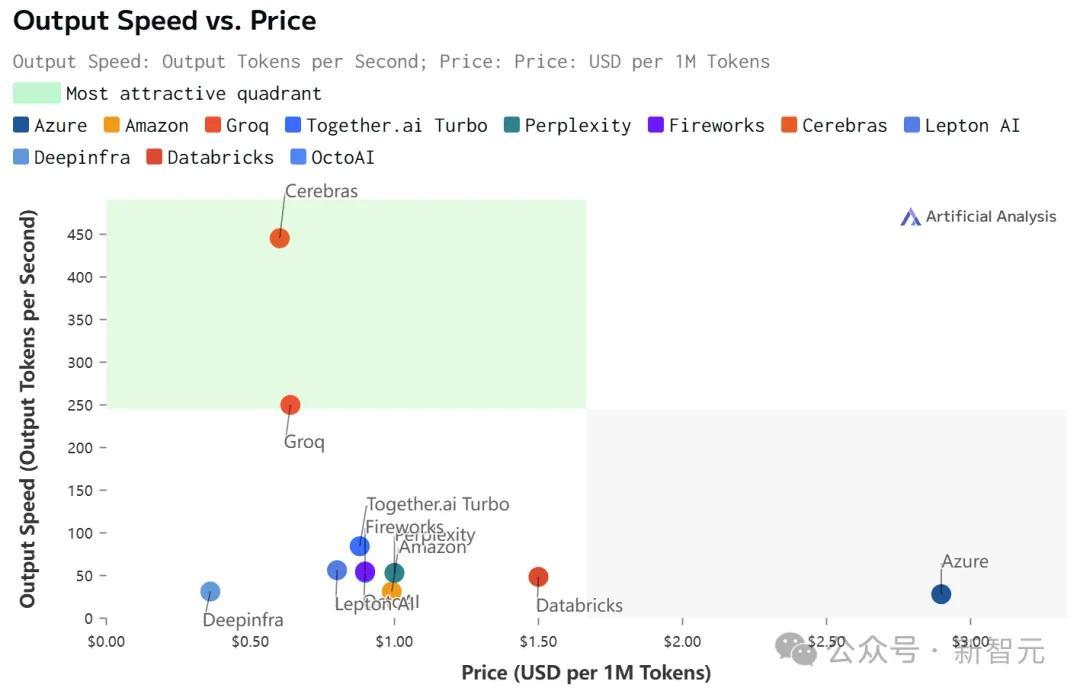

最要道的是,价钱还实惠。

把柄官方API订价,Llama 3.1 8B每百万token仅需10好意思分,Llama 3 70B每百万token仅需60好意思分。

如斯之高的性价比,更是冲破了业界记录——

不仅远超之前的保合手者Groq,况且和其他平台比拟,致使是隔「坐标轴」相望了。

Artificial Analysis

恰是因为Cerebras Inference背后,是由自研的第三代芯片Wafer Scale Engine助力,才得以1/5价钱快速推理Llama3.1。

看到自家模子推理如斯神速,LeCun、Pytorch之父纷繁来源转发起来。

还有网友看后暗意,我想要!

1

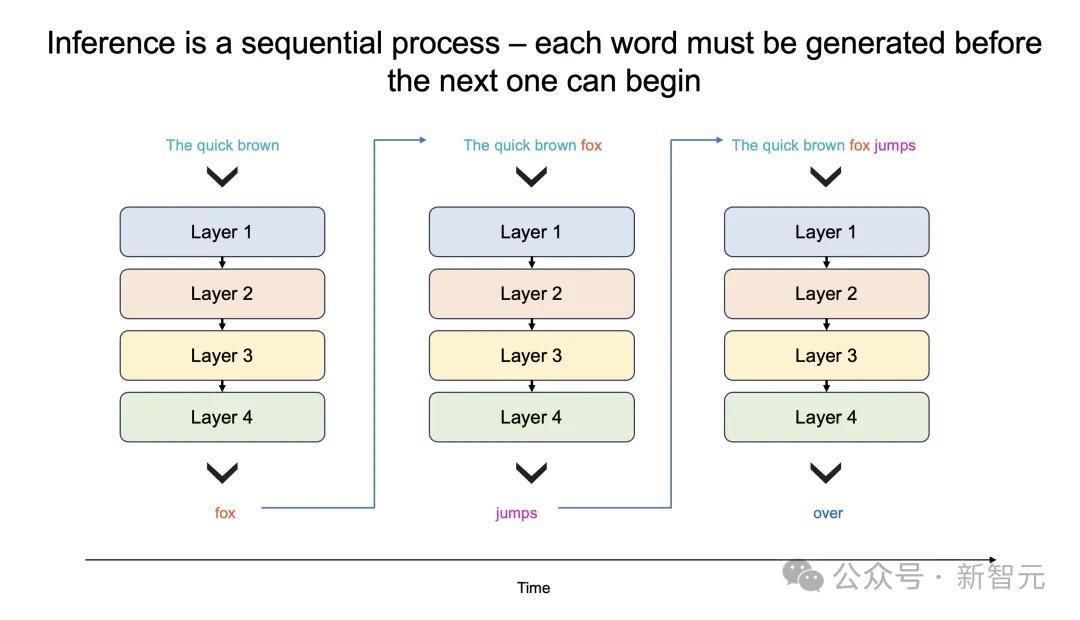

推理很慢,英伟达GPU也不顶用?

为什么LLM的反应,就像拨号上网加载网页一样,一个字一个字迟缓地吐出?

要道原因方位,大模子本人的限定特质,以及需要多量的GPU内存和带宽。

由于GPU的内存带宽收尾,如今推理速率为每秒几十个token,而不是数千个。

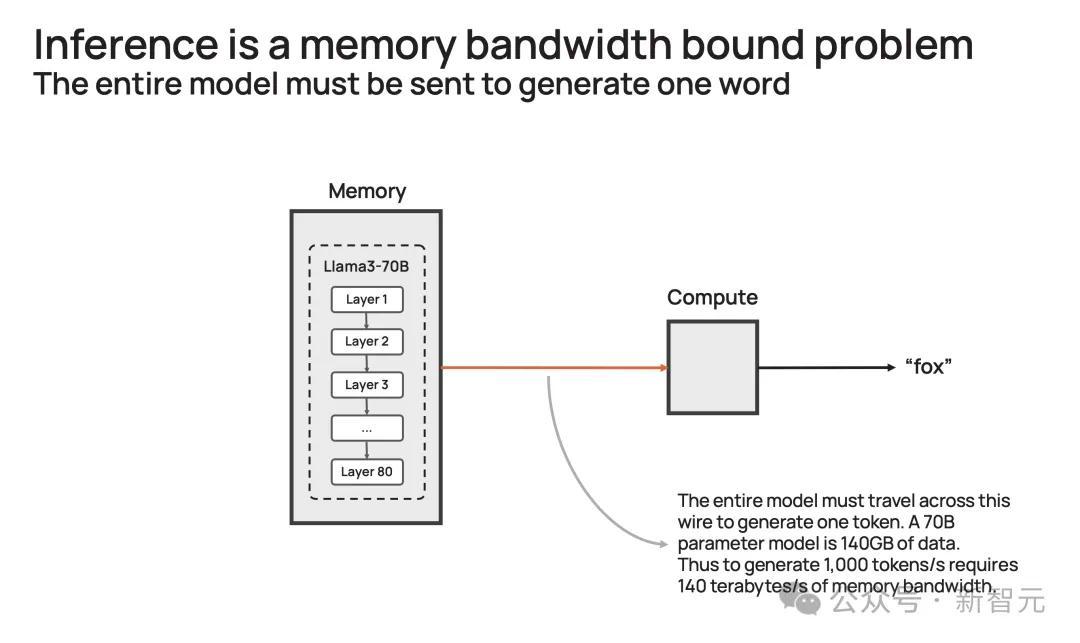

更进一步说,大模子每个生成的单词,都必须通过通盘模子进行处理,即悉数参数必须从内存参加到计较中。

而每生成一个单词,就需要一次处理,以此周而复始。

也等于,生成100个单词需要100次处理,因为「下一词」的展望,皆需要依赖前一个单词,况且这个过程无法并行。

那么,想要每秒生成100个单词,就需要悉数模子参数,每秒参加计较100次。

由此,这对GPU内存带宽提倡了高条款。

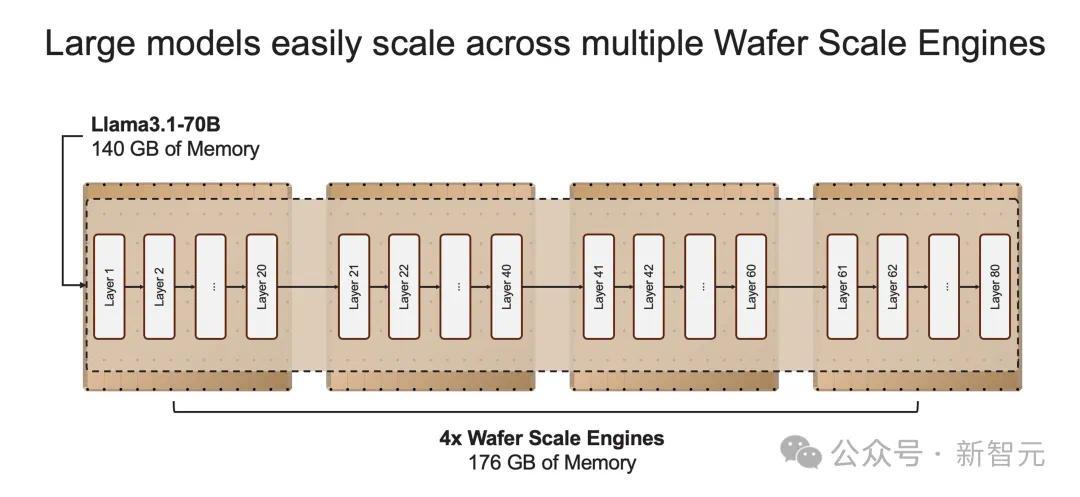

以社区流行的Llama3.1-70B模子为例。

模子有700亿参数,每个参数是16位,需要2字节的存储,那通盘模子便需要140GB的内存。

想要模子输出一个token,那700亿参数必须从内存,移动到计较中枢,以本质前向推理计较。

由于GPU只好约200MB的片上内存,模子无法存储在芯片。

因此,每次生成的token输出时,需将通盘占用140GB内存的模子,齐全传输到计较中。

再细算下来,为了杀青10 token/s,则需要10*140=1.4 TB/s的内存带宽。

那么,一个H100有3.3 TB/s的内存带宽,足以接济这种松弛的推理。

而若要杀青即时推理,需要达到1000 token/s或140 TB/s,这远远高出任何GPU劳动器/系统内存带宽。

大概,你猜想了一种「暴力」经管决策,将多个GPU串联搭建DGX系统。

这皆备是大错特错,更多的处理器只会加多系统的否认量(给出更长反应),并不会加快单个查询的反应期间。

1

自研宇宙最大芯片,冲破推瞎假想

那么,Cerebras何如冲破这一困局呢?

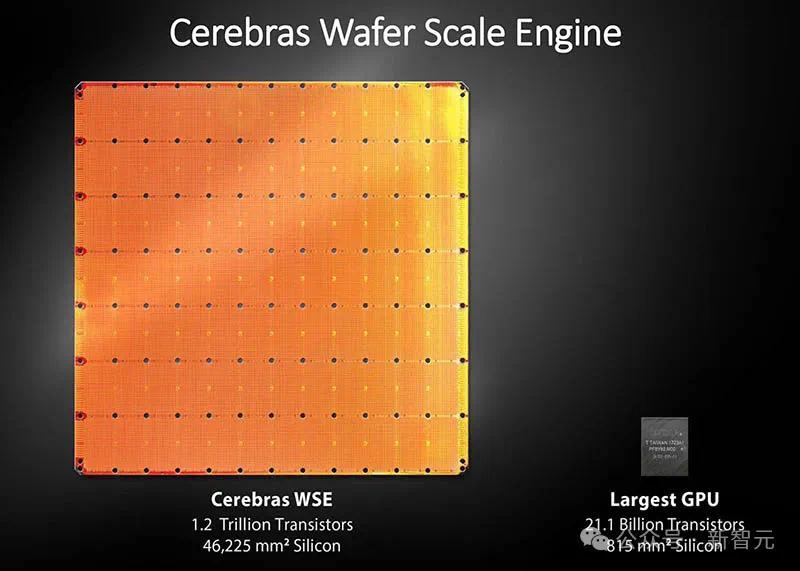

一直以来,这家公司就死力于打造宇宙上最大芯片,但愿将通盘模子存储在一个晶片上,以此来经管内存带宽瓶颈。

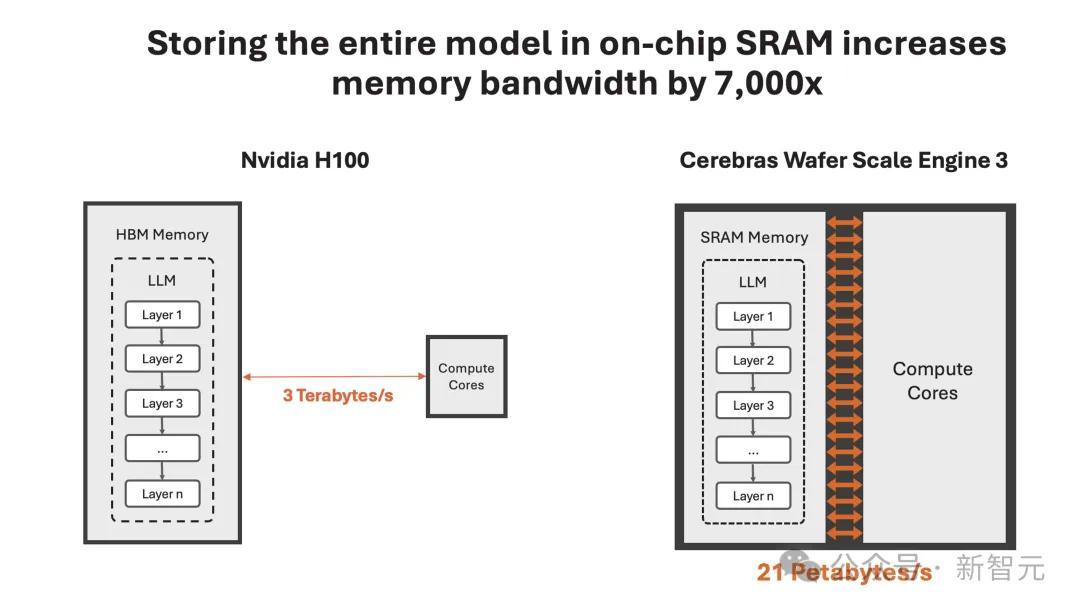

凭借特有的晶圆蓄意,WSE-3单个芯片上便集成了44GB SRAM,具备21 PB/s的内存带宽。

单个芯片领有如斯大内存,便摈斥了对外部内存的需求,以及将外部内存联络到计较的慢速通谈。

总的来说,WSE-3的总内存带宽为21PB/s,是H100的7000倍。

它是独逐个款同期具有PB级计较和PB级内存带宽的AI芯片,使其成为高速推理的近乎瞎想蓄意。

Cerebras推理不仅速率超快,况且否认量普遍。

与袖珍AI芯片比拟,芯片上内存多了约200倍,接济从1-100的批大小,使其在大范围部署时,具有极高的老本效益。

恰是有了如斯强劲的芯片,Cerebras Inference的快速推理得以杀青。

它的出现,是为了杀青数十亿到万亿参数模子的推理。

淌若模子参数高出单个晶圆的内存容量时,商榷东谈主员将在「层范畴」将其拆分,并映射到多个CS-3系统上。

20B模子合适单个CS-3,而70B模子则至少需要4个这么的系统。

官方暗意,异日几周,将会测试更大参数版块的模子,比如Llama3-405B、Mistral Large。

1

16位精度,不作念弃取

推理速率高,并非在模子权重上,作念了弃取。

业界中,一些公司试图将模子权重精度,从16位减少到8位,来克服内存带宽的瓶颈。

这么措施,通常会变成模子精度赔本,也等于反应恶果的准确性、可靠性不如往时。

Cerebras Inference之是以强就强在了,速率和原始权重,皆要顾及。

正如开篇所述,他们接收了原始16位权重来源了Llama3.1 8B和70B。

通过评估,16位模子准确率比8位模子,跨越多达5%。尤其是在,多轮对话、数学和推理任务中剖判更好。

1

最优性价比,百万token免费送

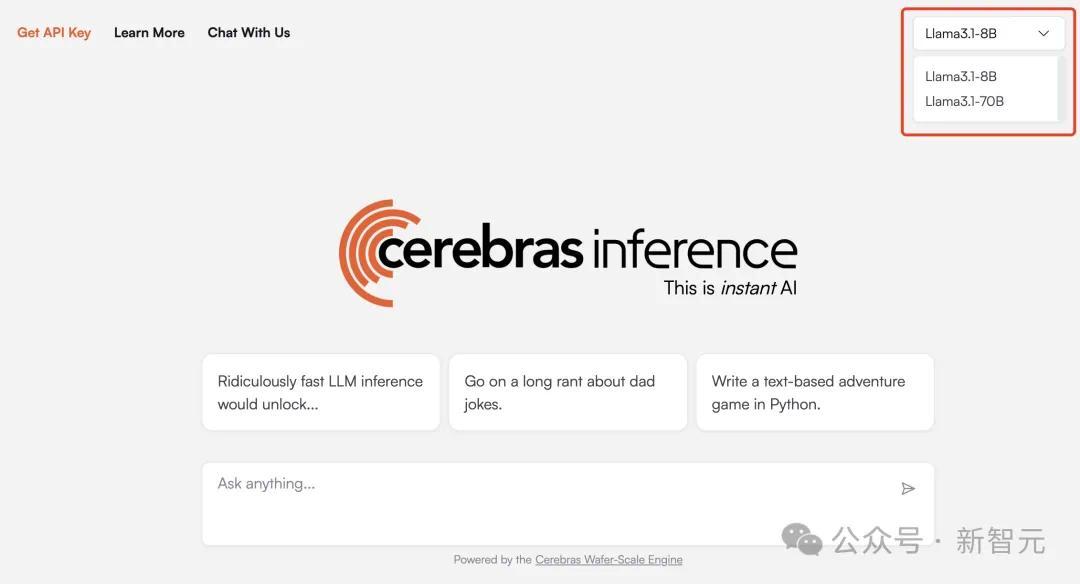

目下,Cerebras Inference可通过聊天平台,以及API拜访,任何一个东谈主可随时体验。

体验传送门:https://cerebras.ai/blog/introducing-cerebras-inference-ai-at-instant-speed

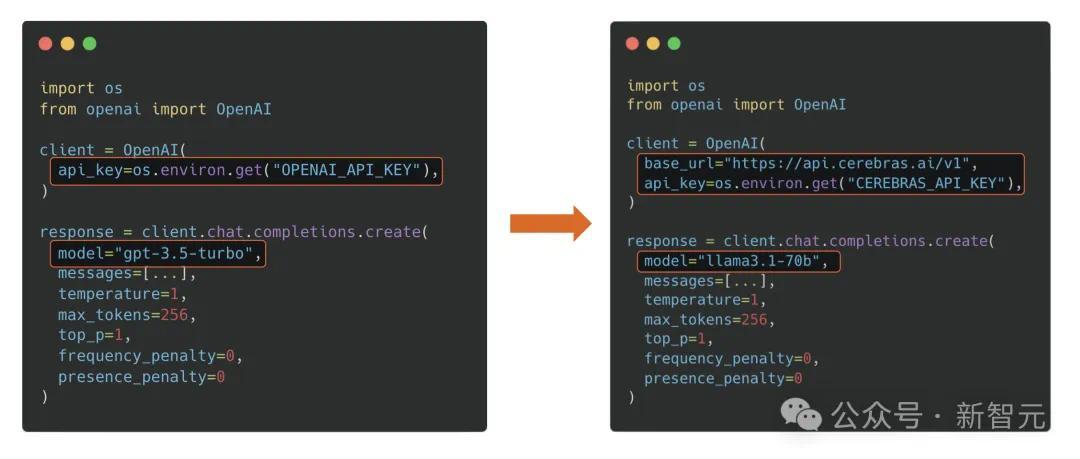

基于熟识的OpenAI Chat Completions形状,诞生者只需更换API密钥即可集成强劲的推理功能。

Cerebras Inference API提供最好的性能、速率、精度和老本组合。

它是独一能即时来源Llama3.1-70B的决策,可杀青450 token/s,相似使用的是原始16位模子权重。

在此,Cerebras奉上大福利,每天为诞生者们提供100万个免费token。关于大范围部署,其订价仅仅H100云的一小部分。

初度推出时,Cerebras提供了Llama3.1 8B和70B模子,况且有才调每天为诞生者和企业,提供数千亿token。

接下来几周,他们将加多对更大模子的接济,如Llama3 405B、Mistral Large 2。

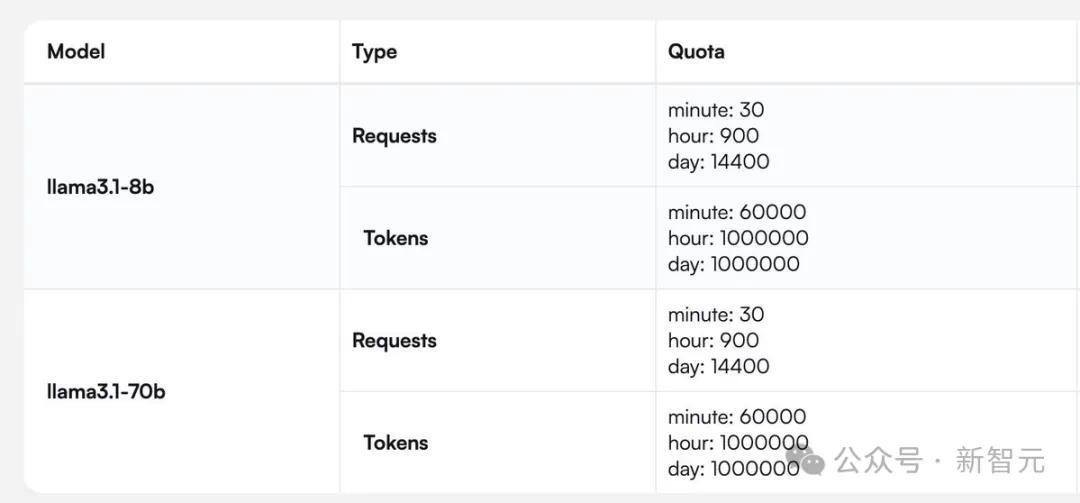

有诞生者问谈,你们提供的rpm(每分钟央求次数)和tpm(每分钟处理token数)是若干?

Cerebras提供了一张针对Llama 3.1 8B和70B模子齐全的央求/token处理数的图。

1

快速推理,不单为速率

临了,让咱们来聊聊,为什么快速推理相配紧迫?

通常,LLM会即刻输出我方的沿路主义,而不议论最好谜底。而诸如scaffolding(脚手架)这类的新技艺,则如并吞个三想此后行的智能体,会在作出决定前探索不同的可能经管决策。

这种「先想考后发言」的方式在代码生成等严苛任务中,不错带来高出10倍的性能擢升,从根底上擢升了AI模子的智能,且无需颠倒检修。

但这些技艺在来源时,需要多达100倍的token。

因此可见,淌若咱们能大幅裁减处理期间,那么就不错杀青更为复杂的AI职责经由,进而实时增强LLM的智能。

1

速率爆表,但凹凸文只好8K

固然在价钱和蔓延上,Cerebras都不是最低的。

但极致的速率,确乎为Cerebras带来了极致的速率-价钱和速率-蔓延比。

不外,值得正式的是,在Cerebras上跑的Llama 3.1,凹凸文只好8k……

比拟之下,其他平台都是128K。

具体数据如下:

Llama 3.1 70B

Llama 3.1 8B